Voir tous les articles

IA

Newsletter

10 min de lecture

EU AI Act Compliance Checker : comprendre et appliquer le AI Act

Publié le :

26 janv. 2026

Découvrez la solution QARA PULSE All-In-One :

Un système intégré complet pour réduire vos cycles réglementaires, fluidifier vos processus et obtenir votre marquage CE plus vite.

30 min • Sans engagement

Rejoignez la newsletter QARA PULSE

Partager

Contexte

Entre enthousiasme et complexité, l’Intelligence Artificielle est en train de redessiner les règles du jeu. Mais pour les entreprises, une question persiste : comment rester innovant tout en restant conforme ?

Publié le 12 juillet 2024 au JOUE et en vigueur depuis le 1er août 2024, le règlement européen sur l’Intelligence Artificielle (AI Act) établit le premier cadre réglementaire mondial consacré à l’IA. Son ambition : garantir que les systèmes d’IA utilisés dans l’Union européenne soient sûrs, transparents et éthiques.

Sur le papier, tout est clair :

- quatre niveaux de risque,

- des obligations proportionnées,

- un cadre harmonisé.

Mais sur le terrain, la réalité est tout autre.

Les frontières entre les niveaux de risque restent floues.

Un même système peut être classé différemment selon son usage, son niveau d’autonomie ou la revendication du fabricant.

Et quand s’ajoutent le MDR, l’IVDR, le RGPD, l’EHDS ou le HTAR, les équipes se retrouvent vite perdues dans les textes.

Ce constat rejoint les conclusions de la Commission européenne dans son étude Study on the deployment of AI in healthcare (2024) :

« Les entreprises du secteur santé, en particulier les PME, peinent à naviguer entre les cadres réglementaires existants.

La fragmentation des exigences et l’absence de lignes directrices intégrées freinent la mise sur le marché et la confiance dans les systèmes d’IA. »

(European Commission, 2024, pp. 40–42)

Pour répondre à cette difficulté, la Commission européenne a lancé la plateforme AI Act Single Information Platform : une nouvelle plateforme unique dédiée à l’information, à la pédagogie et aux outils pratiques de conformité.

Elle rassemble :

- des guides explicatifs et FAQ actualisés pour comprendre les exigences de l’AI Act ;

- des ressources pratiques sur les obligations selon les catégories de risque ;

- et surtout l’accès direct au EU AI Act Compliance Checker : un outil interactif pour identifier son chemin réglementaire.

Cette plateforme constitue désormais le point d’entrée officiel pour tous les acteurs concernés par l’AI Act, et s’impose comme une référence pour structurer la conformité dès les premières étapes du projet.

Faisons le focus sur ce nouvel outil : EU AI Act Compliance Checker.

Objectifs du EU AI Act Compliance Checker

Développé par la Commission européenne dans le cadre de la Single Information Platform, le Compliance Checker vise à rendre la conformité IA accessible.

Il a une double mission :

- aider les entreprises à se positionner dans le cadre du AI Act ;

- poser les premières briques d’une stratégie de conformité structurée et documentée.

En moins de 5 minutes, il permet d’évaluer si un système relève du AI Act, de confirmer son niveau de risque et de clarifier les obligations potentielles associées, à travers une série de questions simples.

C’est un socle de structuration, pas une certification mais un moyen de passer de la théorie à l’action.

Voyons concrètement comment cet outil fonctionne et ce qu’il apporte.

Fonctionnement du EU AI Act Compliance Checker

Accessible directement depuis la plateforme officielle, le Compliance Checker se présente comme un questionnaire interactif.

L’utilisateur y renseigne :

- le type de dispositif évalué (par exemple : modèle ou système d’IA

- son rôle au regard du règlement (fournisseur, déployeur, importateur, distributeur, ou fabricant d’un produit intégrant une IA) ;

- le contexte d’utilisation (mise sur le marché et/ou usage dans l’Union européenne) ;

- les cas d’exclusion éventuels (usage militaire, recherche, activité personnelle,…) ;

- et si le système figure dans l’une des annexes II ou III du AI Act, listant les domaines considérés comme à haut risque

L’outil génère ensuite les résultats de façon synthétique :

- si le système relève du champ d’application du AI Act ;

-le niveau de risque

le rôle réglementaire de l’acteur

et les articles du règlement applicables.

En pratique : le Compliance Checker fournit un cadre initial de structuration utile pour amorcer la démarche de conformité IA sans attendre l’entrée en application complète du règlement.

Limites, précautions d’usage et zones non couvertes

Avant de s’y plonger, il faut savoir ce que le Compliance Checker n’est pas.

❌ Ce qu’il ne fait pas / Ce qu’il n’est pas :

Le EU AI Act Compliance Checker ne valide pas la conformité

- Il ne s’agit pas d’un audit, ni d’une évaluation officielle.

- Il ne délivre pas de certificat, d’avis juridique ou de reconnaissance par une autorité.

- Il ne remplace pas une analyse réglementaire approfondie

- Aucune donnée saisie n’est transmise à la Commission à des fins d’évaluation.

Il ne détermine pas la classe de risque officielle

- Il peut suggérer un niveau de risque mais il ne le confirme pas juridiquement.

- La classification reste à la charge du fabricant ou du fournisseur, sur la base d’une analyse approfondie (article 6 du AI Act).

Il ne couvre pas tous les cas d’usage

Par exemple, il ne prend pas en compte les interactions détaillées entre le AI Act et d’autres cadres réglementaires (MDR, IVDR, RGPD, cybersécurité, etc…).

Il ne propose pas de plan d’action ni de documentation

- L’outil ne fournit pas de rapport téléchargeable complet ni de liste des documents à constituer.

- Il n’oriente pas vers des templates ou bonnes pratiques concrètes.

Il ne vérifie pas la conformité technique des modèles d’IA

Aucun contrôle de qualité des données, de performance algorithmique ou de robustesse logicielle n’est effectué. Ces aspects restent à documenter selon les normes (ISO/IEC 42001, 23894, 62304, etc.).

💡 Ce qu’il fait / Ce qu’il est :

Le EU AI Act Compliance Checker aide à se situer, pas à se conformer.

Il oriente, mais ne certifie rien.

C’est une porte d’entrée pédagogique, pas un outil d’évaluation réglementaire avec pour finalité une certification.

L’approche “risk-based” du AI Act appliquée au secteur santé

L’étude de la Commission européenne sur le déploiement de l’IA en santé (2024) propose une synthèse claire des catégories de risque et des obligations correspondantes pour les systèmes d’IA liés à la santé :

Catégorie de risque | Exemples | Obligations du déployeur (articles AI Act) |

|---|---|---|

Risque inacceptable | Social scoring des individus pour l’accès à des prestations de santé | Interdiction de mise sur le marché et d’usage (Art. 5) |

Risque élevé | Dispositifs médicaux basés sur l’IA relevant du MDR 2017/745 ou IVDR 2017/746 (ex. systèmes d’aide à la décision clinique) IA pour la tarification d’assurance santé IA pour l’évaluation ou le triage d’appels d’urgence IA utilisée par les autorités publiques pour déterminer l’éligibilité à des aides ou services de santé | Mesures de littératie en IA (Art. 4) Utilisation conforme aux instructions (Art. 26(1)) Supervision humaine qualifiée (Art. 26(2)) Données représentatives et pertinentes (Art. 26(4)) Suivi des incidents graves (Art. 26(5), Art. 72) Conservation des journaux d’événements (Art. 26(6)) Enregistrement de certains déployeurs (Art. 26(8), Art. 49) Évaluation d’impact RGPD et droits fondamentaux (Art. 26(9), Art. 27) |

Risque de transparence | Chatbots IA prodiguant des conseils de bien-être “Deepfakes” médicaux générés par IA Détecteurs de mouvement basés sur l’IA en établissements de soins Capteurs d’ingestion automatisés | Mesures de littératie en IA (Art. 4) Obligations de transparence (Art. 50) |

Risque minimal à nul | IA utilisée en recherche pharmaceutique Systèmes d’administration en santé | Aucune exigence spécifique au titre du AI Act |

Source : European Commission – Study on the Deployment of AI in Healthcare, 2024, p. 63.

Ce tableau illustre bien la structure du AI Act : plus le risque associé au système est élevé, plus les exigences de conformité sont strictes.

Mais il présente une vision “macro” — centrée sur les grandes familles d’applications (bien-être, diagnostic, etc.) — sans distinguer les nuances entre dispositifs médicaux de classe I et IIa.

Or, c’est précisément dans ces zones grises que les fabricants ont besoin d’un cadre plus précis.

Un logiciel compagnon de classe I sans fonction de diagnostic n’a pas les mêmes obligations qu’un dispositif d’aide à la décision clinique de classe IIa.

Pourtant, tous deux relève du AI Act.

C’est là qu’intervient le EU AI Act Compliance Checker : un outil pratique conçu pour transposer cette logique “risk-based” à des cas d’usage réels, en tenant compte du rôle de l’acteur (fabricant, fournisseur, distributeur), du contexte d’utilisation et du niveau d’évaluation réglementaire (avec ou sans organisme notifié).

Alors, j’ai testé l’outil Compliance Checker, pour vous !

Cas d’usage pour les dispositifs médicaux

Le EU AI Act Compliance Checker agit comme un outil de positionnement réglementaire : il permet de vérifier si le dispositif relève du AI Act, de caractériser le rôle du fabricant en tant que fournisseur de système d’IA, et de prévisualiser les obligations susceptibles de s’appliquer (transparence, supervision humaine, documentation, évaluation de conformité, etc.).

Dispositif médical de Classe I

Prenons le cas d’un fabricant qui met sur le marché de l’UE un logiciel compagnon qualifié comme un dispositif médical de classe I, sans fonction de diagnostic. Même sans prise de décision clinique, il peut proposer des contenus personnalisés à partir des interactions ou des données collectées, grâce à l’IA.

Lors de la simulation sur le Compliance Checker, j’indique que :

- Le dispositif est considéré comme un système d’IA au sens de l’article 3 du règlement.

- L’acteur a le rôle du fabricant d’un produit (qui renvoit à celui de fournisseur “provider”)

- L’acteur met sur le marché son dispositif au sein de l’UE.

J’exclue toutes les situations pour lesquelles le logiciel pourrait être de risque inacceptable, et donc il n’entre pas dans les systèmes interdits.

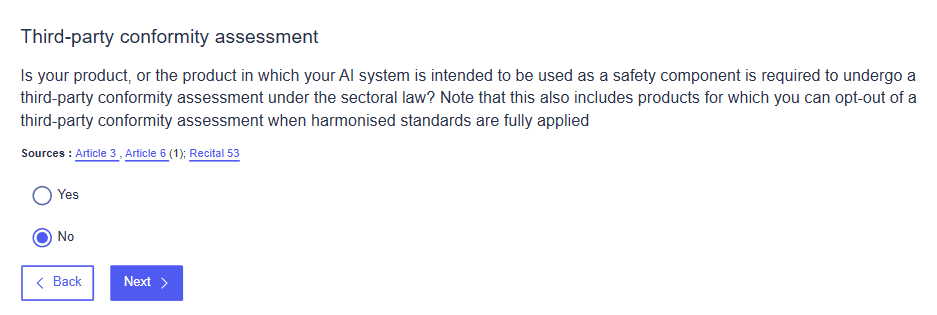

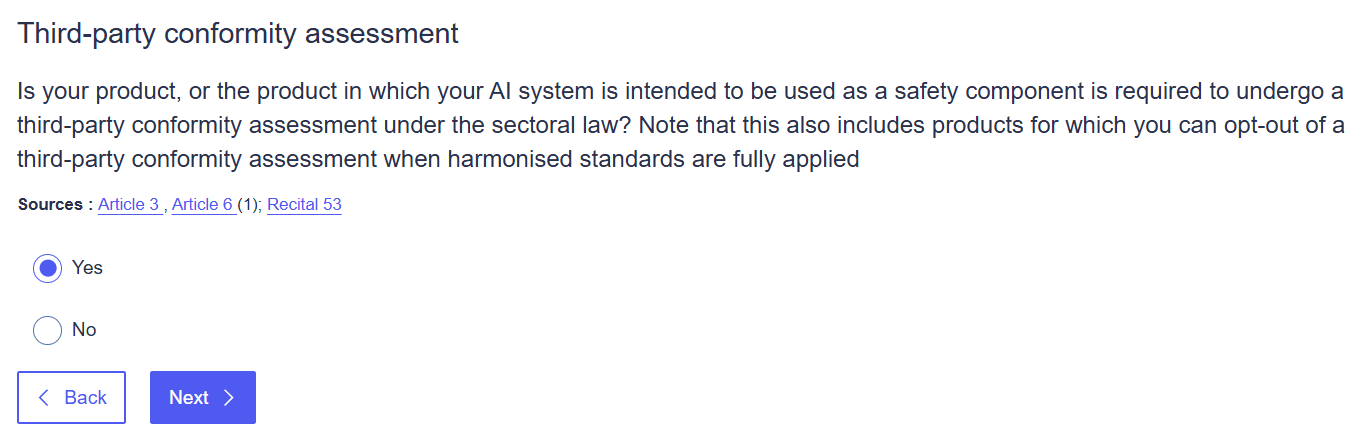

Enfin, j’indique que le dispositif médical n’est pas évalué par un organisme notifié (classe I).

En revanche, j’indique que le logiciel interagit directement avec des personnes physiques et qu’il peut générer des images, des vidéos, du texte.

Résultat du EU AI Act Compliance Checker : Cas d’usage avec un DM de Classe I

Le Compliance Checker confirme que le logiciel relève du AI Act, n’est pas à haut risque, et qu’il est soumis aux obligations de transparence (Art. 50) et de littératie en IA (Art. 4).

J’ai décidé de retranscrire ces obligations sous forme de tableau pour faciliter la lecture :

Domaine | Obligation principale | Référence AI Act |

|---|---|---|

Transparence | Informer l’utilisateur qu’il interagit avec une IA ou un contenu généré artificiellement | Art. 50 |

Culture de l’IA | Assurer un niveau suffisant de compréhension et de formation interne sur l’IA | Art. 4 |

Selon l’article 50 du AI Act, les systèmes d’IA qui interagissent directement avec des personnes doivent informer clairement les utilisateurs qu’ils interagissent avec une intelligence artificielle.

- informer explicitement les utilisateurs : “Vous interagissez avec un système d’intelligence artificielle” ;

- signaler à l’utilisateur les contenus générés artificiellement (icône, mention dans l’interface, ou notice, texte, image, voix) ;

- conserver une traçabilité de ces informations dans la documentation technique MDR.

L’article 4 du AI Act introduit une exigence de “AI literacy” :

- former ou sensibiliser les équipes internes (qualité, développement, clinique) aux bases de l’IA et de la transparence ;

- inclure dans la notice utilisateur des informations claires sur la nature et les limites du système d’IA ;

- documenter ces actions de sensibilisation dans le système qualité ou le rapport de gestion des risques.

Ce résultat permet au fabricant de poser un premier cadre clair en parfaite cohérence avec le AI Act qui consiste à s’assurer que les utilisateurs savent qu’ils interagissent avec un système d’IA, et que les équipes internes comprennent son fonctionnement et ses limites.

Pour un dispositif médical de classe I, le Compliance Checker confirme donc bien que :

- le produit relève du AI Act ;

- il n’est pas classé à haut risque ;

- les obligations portent uniquement sur la transparence et la sensibilisation à l’IA.

L’outil permet ainsi de valider rapidement le positionnement réglementaire du dispositif et de poser les premières bases d’une conformité AI Act, cohérente avec le MDR.

Dispositif médical de Classe IIa

Prenons maintenant le cas d’un dispositif médical de classe IIa, intégrant un module d’aide à la décision clinique. Dans cet exemple, le fabricant du dispositif est toujours considéré comme fournisseur (provider) du système d’IA au sens du AI Act.

Lors de la simulation du EU AI Act Compliance Checker, contrairement à l’exemple du dispositif médical de classe I, j’indique cette fois-ci que le logiciel est évalué par un organisme tiers (l’organisme notifié) car le dispositif est de classe IIa.

Résultat du EU AI Act Compliance Checker : Cas d’usage avec un DM de Classe IIa

Le logiciel est bien considéré comme à haut risque au sens de l’article 6 du AI Act, car :

- il est réglementé par le MDR 2017/745 (Annexe II du AI Act) ;

- et il fait l’objet d’une évaluation de conformité par un organisme notifié.

L’outil affiche une liste beaucoup plus complète d’exigences (en complément de celles déjà citées pour les systèmes à risque limité) et renvoit à un ensemble d’obligations et articles clés.

J’ai décidé de les résumer dans un tableau pour faciliter la lecture :

Domaine | Obligation | Référence (AI Act) |

|---|---|---|

Gestion du risque | Établir un système de gestion du risque couvrant la conception, le développement et le suivi du système | Art. 9 |

Gouvernance des données | Garantir une gouvernance et une gestion adéquate des données d’entraînement, de validation et de test | Art. 10 |

Documentation technique | Rédiger et maintenir une documentation technique complète démontrant la conformité | Art. 11 |

Traçabilité (enregistrement) | Assurer la traçabilité via l’enregistrement et la conservation des logs produits par le système | Art. 12 & 19 |

Transparence et interprétabilité | Permettre aux utilisateurs/déployeurs d’interpréter correctement les résultats produits par l’IA | Art. 13 |

Supervision humaine | Garantir une supervision humaine permettant de corriger, interrompre ou désactiver le système si nécessaire | Art. 14 |

Robustesse, exactitude et cybersécurité | Assurer un niveau approprié de fiabilité, précision et cybersécurité du système | Art. 15 |

Identification du fournisseur | Indiquer le nom, la marque et les coordonnées du fournisseur sur le système, l’emballage ou la documentation | Art. 16(2) |

Système de management de la qualité (SMQ) | Mettre en place un SMQ conforme à l’article 17 pour encadrer la conception, la production et la surveillance | Art. 17 |

Tenue de la documentation | Conserver la documentation prévue à l’article 18 et la maintenir à jour | Art. 18 |

Journalisation et logs | Conserver les journaux d’événements (logs) générés automatiquement par le système | Art. 19 |

Actions correctives | Prendre les mesures correctives nécessaires et fournir les informations requises aux autorités | Art. 20 |

Coopération avec les autorités | Coopérer avec les autorités compétentes nationales en cas de demande ou d’incident | Art. 21 |

Évaluation de conformité | Soumettre le système à la procédure d’évaluation de conformité appropriée | Art. 43 |

Déclaration UE de conformité | Rédiger une déclaration de conformité attestant du respect des exigences du AI Act | Art. 47 |

Marquage CE | Apposer le marquage CE sur le système conformément au AI Act | Art. 48 |

Enregistrement | Enregistrer le système d’IA à haut risque dans la base de données européenne dédiée | Art. 49 |

Accessibilité | Garantir la conformité aux directives d’accessibilité applicables (UE 2016/2102, UE 2019/882) | Art. 16(1)(l) |

Le EU AI Act Compliance Checker place toutes les obligations (conception et performance, organisationnelles ou complémentaires) au même niveau, confirmant qu’ils constituent un ensemble cohérent d’obligations cumulatives pour tout système d’IA à haut risque.

Cette approche cumulative des obligations est cohérente avec les constats de la Commission européenne. Dans son étude sur le déploiement de l’IA en santé (2024), elle rappelle que si le AI Act, le MDR et l’IVDR partagent un objectif commun de sécurité, de performance technique et de conformité, leurs mécanismes de suivi restent distincts. L’étude recommande ainsi de renforcer les dispositifs de surveillance post-déploiement pour favoriser la confiance et l’adoption des technologies d’IA dans le secteur médical.

Regard critique et stratégique QARA

Le EU AI Act Compliance Checker n’est pas seulement un outil d’information : c’est une invitation à structurer sa conformité IA avant qu’elle ne devienne une contrainte et rend la conformité IA plus accessible.

Pour les responsables QARA, l’intérêt de l’outil réside surtout dans sa capacité à anticiper les exigences documentaires et à structurer la réflexion avant l’audit.

En quelques minutes, il aide à clarifier si un système relève du AI Act, à identifier les articles applicables et à se repérer dans les premières obligations comme la transparence (article 50) pour l’exemple du dispositif médical de classe I.

Cependant :

Lorsque de nombreuses exigences deviennent applicables, comme c’est le cas pour un système d’IA à haut risque, il serait encore plus lisible de présenter les résultats sous forme de tableau en catégorisant la nature des obligations (documentaire, technique, réglementaire, etc.). Aujourd’hui, le Compliance Checker ne distingue pas clairement les obligations “techniques” (Art. 8–15) des obligations “organisationnelles” (Art. 16–20) : elles apparaissent au même niveau, comme un socle cumulatif pour le haut risque.

Certains intitulés peuvent prêter à confusion. Dans notre exemple du dispositif médical de classe I, la section “Risk level assessment” ne fournit pas une évaluation du niveau de risque (”limité”). Elle indique simplement si le système d’IA entre dans le champ d’application du AI Act, en se référant à l’article 3(1), qui définit ce qu’est un système d’intelligence artificielle. Autrement dit, il s’agit d’une vérification d’applicabilité, pas d’une classification du risque. Ce point mérite d’être précisé dans l’outil pour éviter les confusions entre applicabilité et classification du risque.

Conformité IA et dispositifs médicaux : une lecture croisée MDR/IVDR x AI Act

Si ces exigences se recoupent largement avec celles du MDR/IVDR, le EU AI Act Compliance Checker ne fait pas de parallèle avec les textes réglementaires sectoriels.

L’outil EU AI Act Compliance Checker a donc le mérite de clarifier les obligations applicables au titre du AI Act, mais il reste sectoriellement neutre.

Pour le secteur des dispositifs médicaux, il serait particulièrement intéressant qu’il établisse des correspondances avec les exigences des règlements MDR 2017/745 ou IVDR 2017/746, notamment sur la gestion du risque, la documentation technique, la traçabilité et la surveillance post-market. Une telle approche permettrait d’éviter les redondances entre cadres réglementaires, de favoriser la cohérence documentaire dans les démarches de conformité, et de renforcer la lisibilité du périmètre de responsabilité entre fabricants, fournisseurs et organismes notifiés.

Cette réflexion rejoint le Position Paper “Artificial Intelligence in Medical Devices” (Team-NB & IG-NB, version 1, 14 novembre 2024), qui reconnaît « un chevauchement considérable entre les exigences du AI Regulation (UE 2024/1689) et le cadre réglementaire et normatif existant pour les logiciels et dispositifs médicaux ».

Cette complémentarité est désormais reconnue au niveau européen.

De manière complémentaire, le MDCG 2025-6 “Interplay between the Medical Devices Regulation & In Vitro Diagnostic Medical Devices Regulation and the Artificial Intelligence Act” (juin 2025), va plus loin en confirmant la coexistence et la complémentarité des deux cadres. Il précise notamment que les fabricants peuvent, conformément à l’article 8(2) du AI Act, intégrer les exigences spécifiques du AI Act (gestion du risque, documentation, données, supervision humaine, etc.) au sein du SMQ déjà établi sous le MDR/IVDR, afin de garantir cohérence et proportionnalité des obligations.

Cette analyse rejoint également les conclusions de la Commission européenne dans son étude Study on the Deployment of AI in Healthcare (2024) :

« Si le AI Act, le MDR et l’IVDR visent tous la sécurité, la performance et la conformité, leur application gagnerait à être mieux articulée.

Des mécanismes complémentaires de suivi post-déploiement seraient nécessaires pour renforcer la confiance et l’adoption de l’IA en santé — un enjeu central pour les fabricants de dispositifs médicaux intégrant de l’intelligence artificielle. »

(European Commission, 2024, p. 65)

Conclusion & perspectives

Le EU AI Act Compliance Checker ne répond pas à tout, mais il offre enfin un premier cadre pour rester innovant tout en restant conforme.

Il permet de comprendre rapidement où l’on se situe dans le cadre du AI Act, sans se perdre dans la complexité du texte.

Il ne remplace pas une analyse réglementaire complète : il oriente, il structure, il guide.

Véritable boussole de la conformité IA, il aide à poser les bases d’une démarche claire et cohérente, en particulier pour les acteurs du secteur santé. Le EU AI Act Compliance Checker n’est pas une fin, mais un bon point de départ pour bâtir le cadre. Il aide les entreprises à organiser leur démarche et préparer la documentation.

Dans l’exemple des dispositifs médicaux, il ne prend pas en compte les exigences sectorielles propres au MDR 2017/745 ou IVDR 2017/746. Il aide à situer le périmètre d’applicabilité, sans détailler l’ensemble des exigences de conformité.

Mais il est amené à évoluer et à s’améliorer avec la pratique, et chacun peut contribuer à son amélioration.

En version beta, vous pouvez participer à son développement. Pour ce faire : écrivez vos commentaires via le formulaire de contact de la Commission européenne.

Il permet déjà de transformer une lecture réglementaire complexe en une démarche de conformité accessible et proactive.

Le défi des prochaines années sera d’intégrer les exigences du AI Act dans les démarches MDR existantes, sans alourdir inutilement les processus.

L’avenir de la conformité IA sera collaboratif, et il commence par des outils simples, accessibles et co-construits — comme ce premier Compliance Checker. En testant, commentant et partageant des outils comme le EU AI Act Compliance Checker, nous contribuons tous à construire une IA européenne responsable, compréhensible et maîtrisée.

Ressources utiles pour aller plus loin

AI Act Single Information Platform – plateforme officielle de la Commission européenne dédiée à la pédagogie et aux outils pratiques de conformité.

Formulaire de contact de la Commission européenne – pour envoyer vos commentaires ou questions sur le AI Act.

Team-NB Position Paper – Artificial Intelligence in Medical Devices (v1, nov. 2024)

MDCG 2025-6 – FAQ on Interplay between MDR/IVDR and the AI Act (June 2025)

European Commission – Study on the Deployment of AI in Healthcare (2024)

ℹ️ L’article est diffusé à titre informatif et ne constitue pas une référence normative ou réglementaire.

Article rédigée par Sophie Colliot

Faites confiance à QARA PULSE

30 min • Sans engagement

Ressources

Découvrez nos ressources.

Avis clients

+15

Clients accompagnés

6 à 12

mois économisés

100%

de clients satisfaits

6

marquages CE obtenus